„On-Device AI“ spricht lokale KI-Modelle am Mac vom iPhone aus an

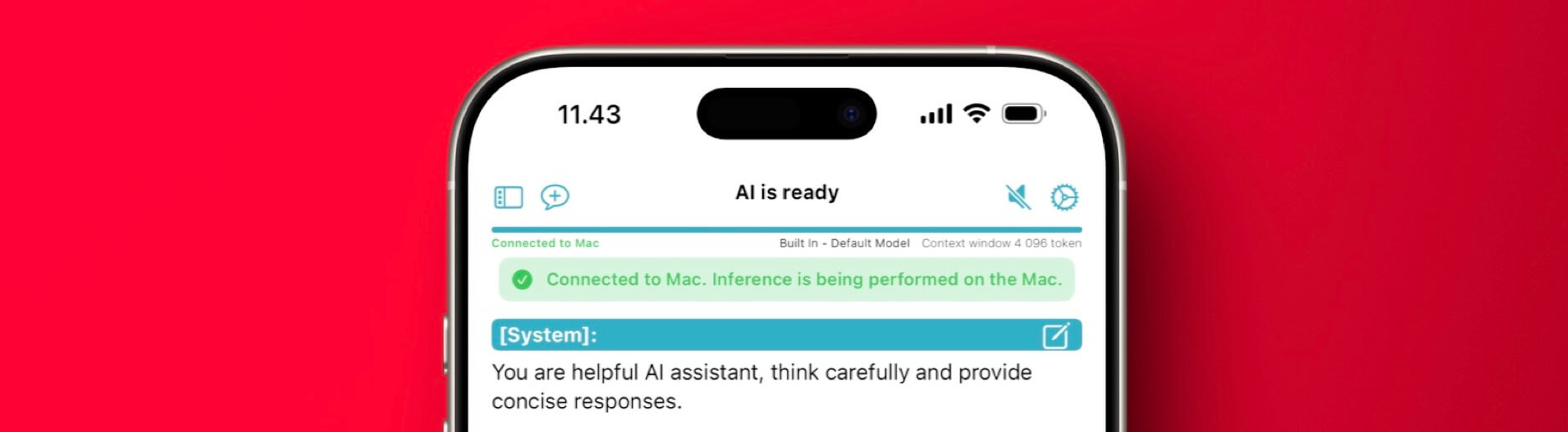

Ergänzend zu „lokale LLM-Sprachmodelle auch unterwegs“: On-Device AI beinhaltet direkt einen Server Mode, der eure (An-)Fragen vom iPhone auf dem eigenen Mac rechnet – gleichermaßen ein privates „Private Cloud Compute“.

Dort laufen leistungsfähigere Modelle, die auf mehr Arbeitsspeicher zugreifen und die den Stromverbrauch nicht interessieren. Mit Tailscale (+ Exit Node) klappt das von überall aus, solange der Mac erreichbar ist.

Aber wie bereits gestern angesprochen: Natürlich sollte Apple eine solche Funktionalität zwischen seinen Computern selbst anbieten.