„Queryable“ durchsucht mit dem Deep-Learning-Modell CLIP eure Fotobibliothek

I built an app called Queryable, which integrates the CLIP model on iOS to search the Photos album OFFLINE. […]

CLIP (Contrastive Language-Image Pre-Training) is a model proposed by OpenAI in 2021. CLIP can encode images and text into representations that can be compared in the same space. CLIP is the basis for many text-to-image models (e.g. Stable Diffusion) to calculate the distance between the generated image and the prompt during training.

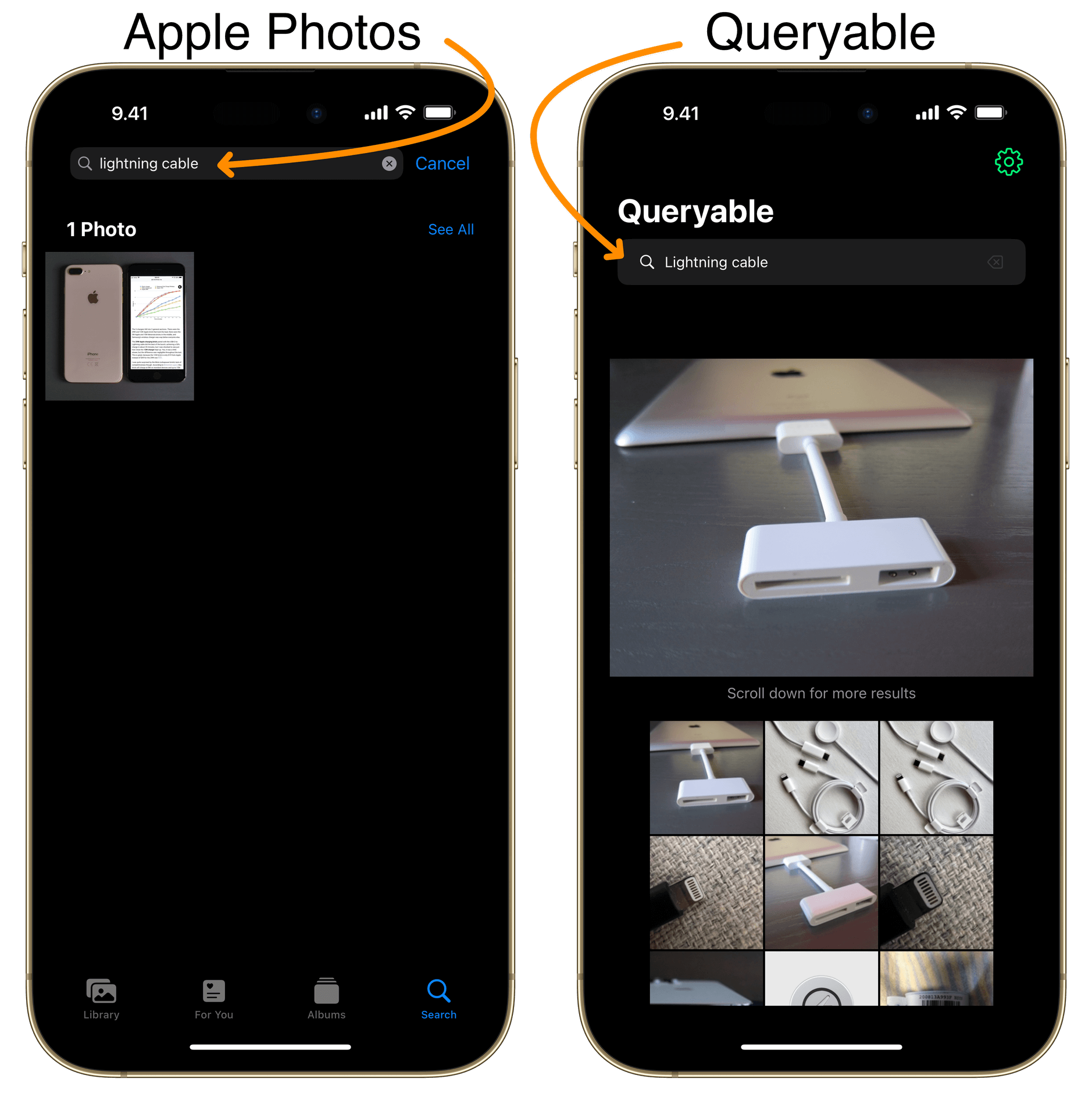

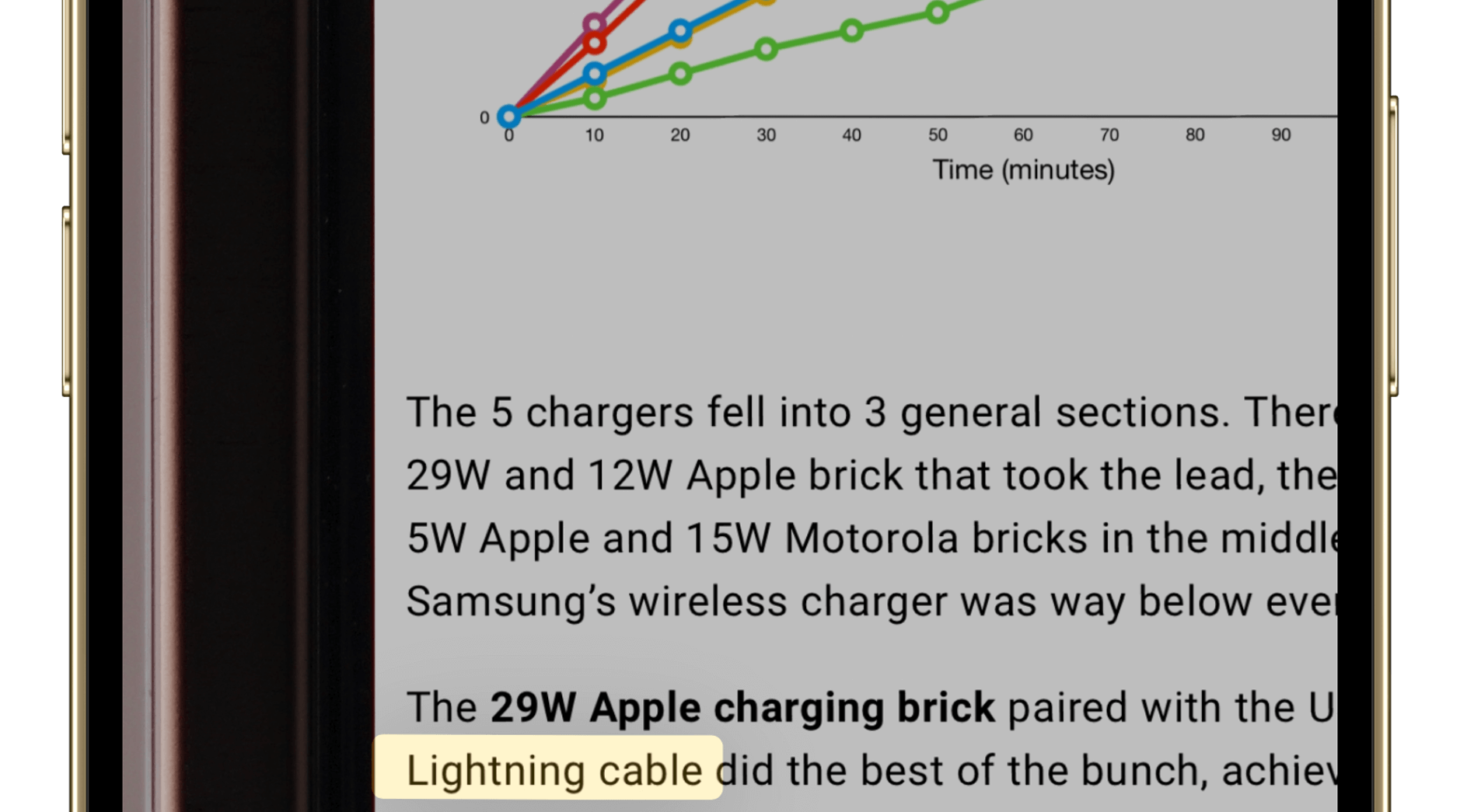

Diese zwei Screenshots demonstrieren, wie viel mehr Treffer Queryable findet, und gleichzeitig wie ungenau es dabei ist. Das geschulte Auge erkennt, dass das hervorgehobene Bild natürlich kein „lightning cable“ ist.

Aber warum zeigt Apples Suche in der Fotos-App ein iPhone? Beim genaueren Hinschauen zeigt sich der erkannte Text.

Queryable erkennt mit seinem KI-Modell nicht spezifisch Text, ordnet aber Wörter und Begriffe dem Bildmaterial zu. Dazu muss es einmalig durch eure Fotodatenbank schauen. 68.000 Bilder indexierte die Neural Engine im iPhone in zirka 15 Minuten. Das geschieht komplett Offline und klappt auch dann, wenn eure Bilder in der iCloud liegen und das iPhone lediglich ein Vorschau-Bild bereithält.

Voraussetzung ist mindestens ein iPhone 11 sowie iOS 16. Bei mir belegt die App nach ihrer Installation und Indexierung zirka 700 Megabyte. Jede einzelne Suchanfrage durch meine Fotobibliothek dauert auf dem iPhone 14 ungefähr fünf Sekunden.

Die Ergebnisse sind lustig, faszinierend, überraschend und zum Haare raufen. Oft sind die Assoziationen nachvollziehbar und geben einen anderen Blick auf die eigenen Bilder.

Die App ist jedoch karg. Es fehlt eine Zählung, wie viele Bilder gefunden wurden. Eine ausgeführte Suche lässt sich nicht erweitern oder modifizieren. Es existiert kein Suchverlauf und neue Bilder müssen von Hand in den Index aufgenommen werden.

Die Technikdemonstration würde ungemein an Wert gewinnen, wenn man ein gefundenes Foto in Queryable an der korrekten Zeitmarke in Apples Foto-App öffnet könnte. Derzeit bekommt man nur das Datum angezeigt und muss selbst scrollen.

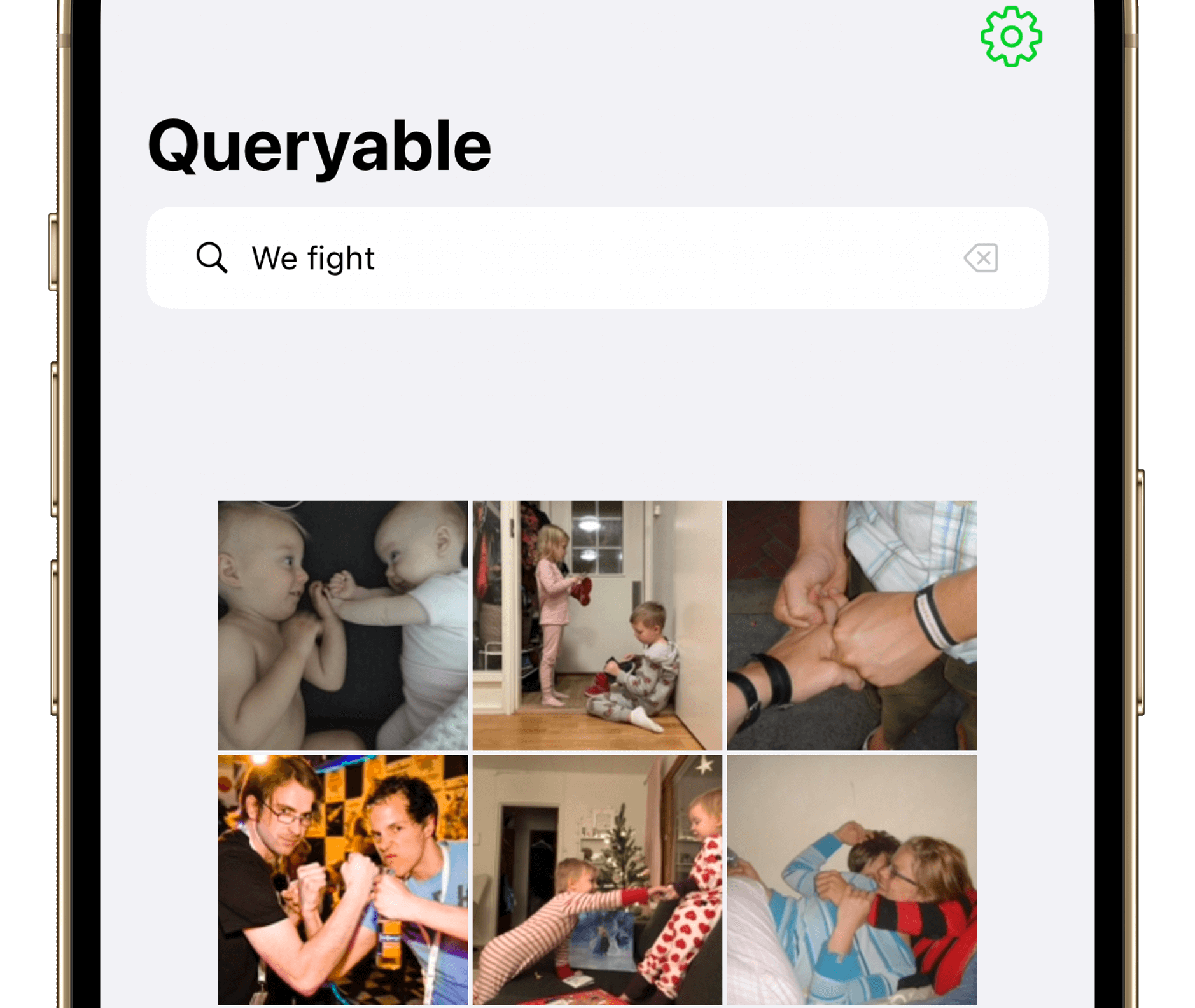

Und trotzdem: Der Bildzuordnung zuzuschauen, insbesondere wenn mehr als nur einzelne Begriffe gesucht werden („We fight“, „We fell in love“), macht den Reiz von Queryable aus.