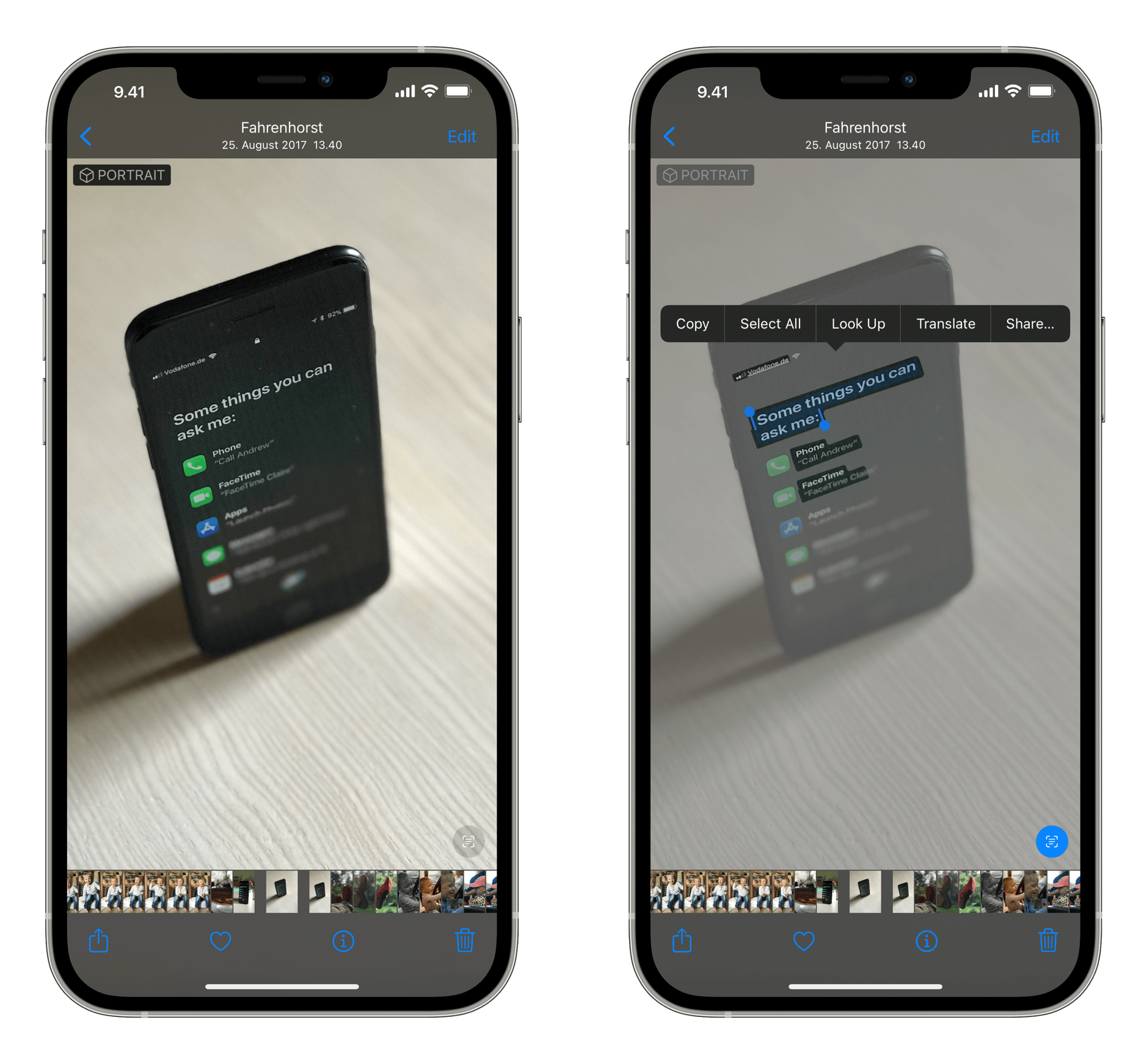

„Livetext“ – ein Augmented-Reality-Feature für die iPhone-Kamera

Livetext nutzt On-Device Intelligenz, um Text in einem Foto zu erkennen und Anwender:innen das Ausführen bestimmter Aktionen zu ermöglichen. So können Nutzer:innen zum Beispiel nach dem Bild eines handgeschriebenen Familienrezepts suchen und es finden oder eine Telefonnummer in einem Schaufenster fotografieren und dort anrufen. Mit der Power der Apple Neural Engine kann die Kamera App auch schnell Text in einem bestimmten Moment erkennen und kopieren, beispielsweise das in einem Café angegebene Wi-Fi Passwort. Mit Visual Look Up können Nutzer:innen mehr über beliebte Kunstwerke und Sehenswürdigkeiten auf der ganzen Welt, Pflanzen und Blumen in der Natur und Tierarten erfahren — und sogar Bücher finden.

Nochmal langsam.

„Livetext“ erkennt (getippten oder handgeschriebenen) Text auf bereits geknipsten Bildern sowie in der Live-Kameraansicht (ab dem iPhone XS). Obendrein findet eine Spotlight-Suche diese Textstücke auch automatisch in eurer Fotobibliothek.

Apple spendierte diesem (ich möchte behaupten) signifikanten Feature – weil’s ein weiterer Schritt in die AR-Zukunft ist – exakt drei Minuten in seiner zweistündigen Keynote.